คำว่า “ข้อมูลขนาดใหญ่” หมายถึงข้อมูลจำนวนมหาศาลที่จัดเก็บไว้ในสื่อใดๆ

- แหล่งข้อมูลขนาดใหญ่

- ประวัติความเป็นมาของการเกิดขึ้นและการพัฒนาของ Big Data

- เทคนิคและวิธีการในการวิเคราะห์และประมวลผลข้อมูลขนาดใหญ่

- แนวโน้มและแนวโน้มการพัฒนาข้อมูลขนาดใหญ่

- ข้อมูลขนาดใหญ่ในด้านการตลาดและธุรกิจ

- ตัวอย่างการใช้ Big Data

- ปัญหาบิ๊กดาต้า

- ตลาดเทคโนโลยีบิ๊กดาต้าในรัสเซียและทั่วโลก

- หนังสือเกี่ยวกับ Big Data ที่ดีที่สุด

ยิ่งไปกว่านั้น โวลุ่มนี้มีขนาดใหญ่มากจนไม่สามารถประมวลผลโดยใช้ซอฟต์แวร์หรือฮาร์ดแวร์ปกติได้ และในบางกรณีก็เป็นไปไม่ได้เลย

ข้อมูลขนาดใหญ่ ไม่ได้เป็นเพียงข้อมูลเท่านั้น แต่ยังรวมถึงเทคโนโลยีสำหรับการประมวลผลและใช้งาน วิธีการในการค้นหาข้อมูลที่จำเป็นในอาร์เรย์ขนาดใหญ่ ปัญหาของบิ๊กดาต้ายังคงเปิดกว้างและมีความสำคัญต่อระบบต่างๆ ที่รวบรวมข้อมูลที่หลากหลายมานานหลายทศวรรษ

แหล่งข้อมูลขนาดใหญ่

เครือข่ายโซเชียลเป็นตัวอย่างของแหล่งข้อมูลขนาดใหญ่โดยทั่วไป แต่ละโปรไฟล์หรือหน้าสาธารณะเป็นเพียงหยดเล็กๆ หยดหนึ่งในมหาสมุทรข้อมูลที่ไม่มีโครงสร้าง นอกจากนี้ โดยไม่คำนึงถึงปริมาณข้อมูลที่จัดเก็บไว้ในโปรไฟล์ใดโปรไฟล์หนึ่ง การโต้ตอบกับผู้ใช้แต่ละรายควรเป็นไปอย่างรวดเร็วที่สุด

ข้อมูลขนาดใหญ่สะสมอย่างต่อเนื่องในเกือบทุกด้านของชีวิตมนุษย์ ซึ่งรวมถึงอุตสาหกรรมใดๆ ที่เกี่ยวข้องกับปฏิสัมพันธ์ของมนุษย์หรือการประมวลผล เหล่านี้คือโซเชียลมีเดียและยาและภาคการธนาคารรวมถึงระบบอุปกรณ์ที่ได้รับผลการคำนวณรายวันมากมาย ตัวอย่างเช่น การสังเกตการณ์ทางดาราศาสตร์ ข้อมูลอุตุนิยมวิทยา และข้อมูลจากอุปกรณ์เสียงของโลก

ข้อมูลจากระบบติดตามต่างๆ แบบเรียลไทม์จะถูกส่งไปยังเซิร์ฟเวอร์ของบริษัทใดบริษัทหนึ่ง การกระจายเสียงทางโทรทัศน์และวิทยุ ฐานการโทรของผู้ให้บริการโทรศัพท์เคลื่อนที่ – ปฏิสัมพันธ์ของแต่ละคนกับพวกเขานั้นน้อยมาก แต่โดยรวมแล้ว ข้อมูลทั้งหมดนี้กลายเป็นข้อมูลขนาดใหญ่

เทคโนโลยีข้อมูลขนาดใหญ่ได้กลายเป็นส่วนสำคัญในการวิจัยและพัฒนาและการพาณิชย์ ยิ่งกว่านั้น พวกเขากำลังเริ่มจับขอบเขตของการบริหารราชการ – และทุกที่จำเป็นต้องมีการแนะนำระบบที่มีประสิทธิภาพมากขึ้นสำหรับการจัดเก็บและจัดการข้อมูล

ประวัติความเป็นมาของการเกิดขึ้นและการพัฒนาของ Big Data

คำว่า “ข้อมูลขนาดใหญ่” ปรากฏตัวครั้งแรกในสื่อในปี 2008 เมื่อบรรณาธิการ Nature Clifford Lynch ตีพิมพ์บทความเกี่ยวกับวิธีการพัฒนาอนาคตของวิทยาศาสตร์ด้วยความช่วยเหลือของเทคโนโลยีข้อมูลขนาดใหญ่ จนถึงปี 2009 คำนี้ได้รับการพิจารณาจากมุมมองของการวิเคราะห์ทางวิทยาศาสตร์เท่านั้น แต่หลังจากการตีพิมพ์บทความเพิ่มเติมอีกหลายบทความ สื่อมวลชนเริ่มใช้แนวคิดของ Big Data อย่างกว้างขวางและยังคงใช้อยู่ในปัจจุบัน

ในปี 2010 ความพยายามครั้งแรกในการแก้ปัญหาการเติบโตของข้อมูลขนาดใหญ่เริ่มปรากฏขึ้น มีการเปิดตัวผลิตภัณฑ์ซอฟต์แวร์ซึ่งมีจุดประสงค์เพื่อลดความเสี่ยงเมื่อใช้อาร์เรย์ข้อมูลขนาดใหญ่

ภายในปี 2011 บริษัทขนาดใหญ่ เช่น Microsoft, Oracle, EMC และ IBM เริ่มให้ความสนใจในข้อมูลขนาดใหญ่ โดยเป็นบริษัทแรกๆ ที่ใช้ Big data ในกลยุทธ์การพัฒนา และค่อนข้างประสบความสำเร็จ

มหาวิทยาลัยต่างๆ เริ่มศึกษาข้อมูลขนาดใหญ่เป็นวิชาแยกต่างหากในปี 2013 – ตอนนี้ไม่เพียงแต่วิทยาศาสตร์ข้อมูลเท่านั้น แต่ยังรวมถึงวิศวกรรมศาสตร์ ร่วมกับวิชาคอมพิวเตอร์ด้วย กำลังเผชิญกับปัญหาในด้านนี้

เทคนิคและวิธีการในการวิเคราะห์และประมวลผลข้อมูลขนาดใหญ่

วิธีหลักในการวิเคราะห์และประมวลผลข้อมูลมีดังต่อไปนี้:

วิธีการเรียนหรือการทำเหมืองข้อมูล

วิธีการเหล่านี้มีมากมาย แต่รวมเป็นหนึ่งเดียว: เครื่องมือทางคณิตศาสตร์ที่ใช้ร่วมกับความสำเร็จในด้านเทคโนโลยีสารสนเทศ

คราวด์ซอร์สซิ่ง

เทคนิคนี้ช่วยให้คุณรับข้อมูลจากหลาย ๆ แหล่งพร้อมกันและจำนวนหลังนั้นไม่ จำกัด ในทางปฏิบัติ

การทดสอบ A/B

จากจำนวนข้อมูลทั้งหมด จะมีการเลือกชุดควบคุมขององค์ประกอบ ซึ่งจะถูกเปรียบเทียบกับชุดอื่นๆ ที่คล้ายคลึงกัน ซึ่งหนึ่งในองค์ประกอบที่มีการเปลี่ยนแปลง การดำเนินการทดสอบดังกล่าวจะช่วยกำหนดว่าความผันผวนของพารามิเตอร์ใดที่ส่งผลกระทบมากที่สุดต่อประชากรกลุ่มควบคุม ต้องขอบคุณ Big Data ที่มีปริมาณมาก ทำให้สามารถทำซ้ำได้หลายครั้ง โดยแต่ละครั้งจะได้ผลลัพธ์ที่น่าเชื่อถือที่สุด

การวิเคราะห์เชิงคาดการณ์

ผู้เชี่ยวชาญในสาขานี้พยายามที่จะทำนายและวางแผนล่วงหน้าว่าวัตถุที่ควบคุมจะมีพฤติกรรมอย่างไร เพื่อที่จะตัดสินใจได้เปรียบที่สุดในสถานการณ์นี้

การเรียนรู้ของเครื่อง (ปัญญาประดิษฐ์)

โดยอิงจากการวิเคราะห์ข้อมูลเชิงประจักษ์และการสร้างอัลกอริธึมการเรียนรู้ด้วยตนเองสำหรับระบบในภายหลัง

การวิเคราะห์เครือข่าย

วิธีที่พบบ่อยที่สุดสำหรับการศึกษาเครือข่ายสังคม – หลังจากได้รับข้อมูลสถิติแล้วจะมีการวิเคราะห์โหนดที่สร้างขึ้นในกริดนั่นคือการโต้ตอบระหว่างผู้ใช้แต่ละรายและชุมชนของพวกเขา

แนวโน้มและแนวโน้มการพัฒนาข้อมูลขนาดใหญ่

ในปี 2560 เมื่อข้อมูลขนาดใหญ่ไม่ใช่สิ่งใหม่และไม่รู้จักอีกต่อไป ความสำคัญของข้อมูลไม่ได้ลดลงเพียงเท่านั้น แต่ยังเพิ่มขึ้นอีกด้วย ตอนนี้ผู้เชี่ยวชาญกำลังเดิมพันว่าการวิเคราะห์ข้อมูลจำนวนมากจะพร้อมใช้งานไม่เฉพาะสำหรับองค์กรขนาดใหญ่เท่านั้น แต่ยังรวมถึงธุรกิจขนาดเล็กและขนาดกลางด้วย แนวทางนี้มีการวางแผนว่าจะดำเนินการโดยใช้องค์ประกอบต่อไปนี้:

ที่เก็บข้อมูลบนคลาวด์

การจัดเก็บและประมวลผลข้อมูลเริ่มเร็วขึ้นและประหยัดมากขึ้น เมื่อเทียบกับค่าใช้จ่ายในการบำรุงรักษาศูนย์ข้อมูลของคุณเองและการขยายพนักงานออกไป การเช่าระบบคลาวด์ดูเหมือนจะเป็นทางเลือกที่ถูกกว่ามาก

การใช้ Dark Data

ที่เรียกว่า “ข้อมูลมืด” เป็นข้อมูลที่ไม่ใช่ดิจิทัลทั้งหมดเกี่ยวกับบริษัทที่ไม่ได้มีบทบาทสำคัญในการใช้งานโดยตรง แต่อาจเป็นเหตุผลในการเปลี่ยนไปใช้รูปแบบการจัดเก็บข้อมูลใหม่

ปัญญาประดิษฐ์และการเรียนรู้เชิงลึก

เทคโนโลยีการเรียนรู้ของเครื่องจักรซึ่งเลียนแบบโครงสร้างและการทำงานของสมองมนุษย์ เหมาะที่สุดสำหรับการประมวลผลข้อมูลที่เปลี่ยนแปลงตลอดเวลาจำนวนมาก ในกรณีนี้ เครื่องจักรจะทำทุกอย่างที่บุคคลต้องทำ แต่ความน่าจะเป็นของข้อผิดพลาดจะลดลงอย่างมาก

บล็อคเชน

เทคโนโลยีนี้ช่วยให้คุณเพิ่มความเร็วและลดความซับซ้อนของการทำธุรกรรมทางอินเทอร์เน็ตจำนวนมาก รวมถึงธุรกรรมระหว่างประเทศ ข้อดีอีกประการของ Blockchain คือช่วยลดต้นทุนการทำธุรกรรม

บริการตนเองและลดราคา

ในปี 2560 มีการวางแผนที่จะแนะนำ “แพลตฟอร์มแบบบริการตนเอง” ซึ่งเป็นแพลตฟอร์มฟรีที่ตัวแทนของธุรกิจขนาดเล็กและขนาดกลางจะสามารถประเมินข้อมูลที่พวกเขาจัดเก็บและจัดระบบได้อย่างอิสระ

ข้อมูลขนาดใหญ่ในด้านการตลาดและธุรกิจ

กลยุทธ์ทางการตลาดทั้งหมดขึ้นอยู่กับการจัดการข้อมูลและการวิเคราะห์ข้อมูลที่มีอยู่ นั่นคือเหตุผลที่การใช้ข้อมูลขนาดใหญ่สามารถทำนายและทำให้สามารถปรับการพัฒนาของบริษัทต่อไปได้

ตัวอย่างเช่น การประมูล RTB ที่สร้างขึ้นจากข้อมูลขนาดใหญ่ทำให้คุณสามารถใช้โฆษณาได้อย่างมีประสิทธิภาพมากขึ้น ผลิตภัณฑ์บางอย่างจะแสดงเฉพาะกับกลุ่มผู้ใช้ที่สนใจซื้อเท่านั้น

ประโยชน์ของการใช้เทคโนโลยีบิ๊กดาต้าในด้านการตลาดและธุรกิจคืออะไร

- ด้วยความช่วยเหลือของพวกเขา คุณสามารถสร้างโครงการใหม่ได้เร็วกว่ามาก ซึ่งน่าจะเป็นที่นิยมในหมู่ผู้ซื้อ

- ช่วยเชื่อมโยงความต้องการของลูกค้ากับบริการที่มีอยู่หรือที่วางแผนไว้ และปรับเปลี่ยนได้

- วิธี Big Data ช่วยให้คุณประเมินระดับความพึงพอใจในปัจจุบันของผู้ใช้ทั้งหมดและแต่ละคนได้

- เพิ่มความภักดีของลูกค้าด้วยวิธีการประมวลผลข้อมูลขนาดใหญ่

- การดึงดูดผู้ชมเป้าหมายบนอินเทอร์เน็ตทำได้ง่ายขึ้นเนื่องจากสามารถควบคุมข้อมูลจำนวนมหาศาลได้

ตัวอย่างเช่น หนึ่งในบริการยอดนิยมสำหรับการคาดการณ์ความนิยมที่มีแนวโน้มของผลิตภัณฑ์เฉพาะคือ Google.trends มีการใช้กันอย่างแพร่หลายโดยนักการตลาดและนักวิเคราะห์ ทำให้พวกเขาได้รับสถิติเกี่ยวกับการใช้ผลิตภัณฑ์ที่กำหนดในอดีตและการคาดการณ์สำหรับฤดูกาลหน้า ซึ่งช่วยให้ผู้นำบริษัทกระจายงบประมาณการโฆษณาได้อย่างมีประสิทธิภาพมากขึ้น กำหนดว่าควรลงทุนด้านใดดีที่สุด

ตัวอย่างการใช้ Big Data

การนำเทคโนโลยีบิ๊กดาต้าออกสู่ตลาดและเข้าสู่ชีวิตสมัยใหม่อย่างแข็งขันเริ่มขึ้นหลังจากเริ่มใช้งานโดยบริษัทที่มีชื่อเสียงระดับโลกซึ่งมีลูกค้าในเกือบทุกมุมโลก

เหล่านี้เป็นยักษ์ใหญ่ทางสังคมเช่น Facebook และ Google, IBM เช่นเดียวกับโครงสร้างทางการเงินเช่น Master Card, VISA และ Bank of America

ตัวอย่างเช่น IBM กำลังใช้เทคนิคบิ๊กดาต้าในการทำธุรกรรมเงินสด ด้วยความช่วยเหลือของพวกเขา ตรวจพบธุรกรรมที่เป็นการฉ้อโกงเพิ่มขึ้น 15% ซึ่งเพิ่มจำนวนเงินที่ได้รับการคุ้มครอง 60% ปัญหาเกี่ยวกับผลบวกที่ผิดพลาดของระบบก็ได้รับการแก้ไขเช่นกัน – จำนวนของพวกเขาลดลงมากกว่าครึ่ง

VISA ก็ใช้ Big Data ในทำนองเดียวกันเพื่อติดตามความพยายามที่ฉ้อโกงในการทำธุรกรรมบางอย่าง ด้วยเหตุนี้พวกเขาจึงสามารถประหยัดเงินได้มากกว่า 2 พันล้านดอลลาร์สหรัฐต่อปีจากการรั่วไหล

กระทรวงแรงงานของเยอรมนีสามารถลดต้นทุนได้ 10 พันล้านยูโร โดยการใช้ระบบบิ๊กดาต้าในการออกสวัสดิการการว่างงาน ในขณะเดียวกัน ก็เปิดเผยว่าประชาชน 1 ใน 5 ได้รับผลประโยชน์เหล่านี้โดยไม่มีเหตุอันสมควร

บิ๊กดาต้าไม่ได้ข้ามอุตสาหกรรมเกมเช่นกัน ดังนั้น ผู้พัฒนา World of Tanks ได้ทำการศึกษาข้อมูลเกี่ยวกับผู้เล่นทุกคน และเปรียบเทียบตัวชี้วัดที่มีอยู่ของกิจกรรมของพวกเขา สิ่งนี้ช่วยในการทำนายการเปลี่ยนแปลงในอนาคตของผู้เล่น – จากสมมติฐานที่ทำขึ้น ตัวแทนขององค์กรสามารถโต้ตอบกับผู้ใช้ได้อย่างมีประสิทธิภาพมากขึ้น

องค์กรที่มีชื่อเสียงที่ใช้บิ๊กดาต้ายังรวมถึง HSBC, Nasdaq, Coca-Cola, Starbucks และ AT&T

ปัญหาบิ๊กดาต้า

ปัญหาที่ใหญ่ที่สุดของข้อมูลขนาดใหญ่คือค่าใช้จ่ายในการประมวลผล ซึ่งอาจรวมถึงทั้งอุปกรณ์ราคาแพงและค่าจ้างสำหรับผู้เชี่ยวชาญที่ผ่านการรับรองซึ่งสามารถให้บริการข้อมูลจำนวนมหาศาลได้ เห็นได้ชัดว่าอุปกรณ์จะต้องได้รับการปรับปรุงอย่างสม่ำเสมอเพื่อไม่ให้สูญเสียประสิทธิภาพขั้นต่ำเมื่อปริมาณข้อมูลเพิ่มขึ้น

ปัญหาที่สองเกี่ยวข้องกับข้อมูลจำนวนมากที่ต้องดำเนินการอีกครั้ง ตัวอย่างเช่น หากการศึกษาไม่ได้ให้ผลลัพธ์ 2-3 รายการ แต่ให้ผลลัพธ์จำนวนมาก เป็นการยากมากที่จะคงวัตถุประสงค์และเลือกจากสตรีมข้อมูลทั่วไปเฉพาะรายการที่จะมีผลกระทบอย่างแท้จริงต่อสถานะของปรากฏการณ์

ปัญหาความเป็นส่วนตัวของข้อมูลขนาดใหญ่ เนื่องจากการให้บริการลูกค้าส่วนใหญ่เปลี่ยนไปใช้ข้อมูลออนไลน์ จึงเป็นเรื่องง่ายมากที่จะกลายเป็นเป้าหมายต่อไปของอาชญากรไซเบอร์ แม้แต่การจัดเก็บข้อมูลส่วนบุคคลโดยไม่ได้ทำธุรกรรมออนไลน์ใดๆ ก็อาจเต็มไปด้วยผลที่ไม่พึงประสงค์สำหรับลูกค้าที่เก็บข้อมูลบนคลาวด์

ปัญหาข้อมูลสูญหาย ข้อควรระวังไม่ได้จำกัดอยู่เพียงการสำรองข้อมูลเพียงครั้งเดียวอย่างง่าย แต่ต้องทำสำเนาสำรองอย่างน้อย 2-3 สำเนาของที่จัดเก็บข้อมูล อย่างไรก็ตาม เมื่อปริมาณเพิ่มขึ้น ความซับซ้อนของความซ้ำซ้อนก็เพิ่มขึ้น และผู้เชี่ยวชาญด้านไอทีก็พยายามหาทางออกที่ดีที่สุดสำหรับปัญหานี้

ตลาดเทคโนโลยีบิ๊กดาต้าในรัสเซียและทั่วโลก

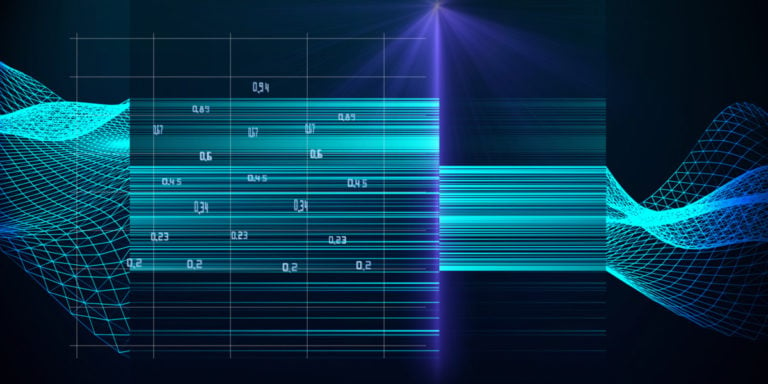

ณ ปี 2014 40% ของตลาดข้อมูลขนาดใหญ่คือบริการ ตัวบ่งชี้นี้ด้อยกว่าเล็กน้อย (38%) เล็กน้อยคือรายได้จากการใช้ Big Data ในอุปกรณ์คอมพิวเตอร์ ส่วนที่เหลืออีก 22% อยู่ในซอฟต์แวร์

ผลิตภัณฑ์ที่มีประโยชน์มากที่สุดในเซ็กเมนต์ระดับโลกสำหรับการแก้ปัญหา Big Data ตามสถิติคือแพลตฟอร์มการวิเคราะห์ในหน่วยความจำและ NoSQL ตลาด 15 และ 12 เปอร์เซ็นต์ตามลำดับถูกครอบครองโดยซอฟต์แวร์วิเคราะห์ไฟล์บันทึกและแพลตฟอร์มแบบเสา แต่ในทางปฏิบัติ Hadoop / MapReduce จัดการกับปัญหาของข้อมูลขนาดใหญ่ไม่ได้ผลมากนัก

ผลลัพธ์ของการใช้เทคโนโลยีบิ๊กดาต้า:

- เติบโตในด้านคุณภาพการบริการลูกค้า

- เพิ่มประสิทธิภาพการบูรณาการห่วงโซ่อุปทาน

- การเพิ่มประสิทธิภาพการวางแผนองค์กร

- เร่งปฏิสัมพันธ์กับลูกค้า

- ปรับปรุงประสิทธิภาพของการประมวลผลคำขอของลูกค้า

- ลดต้นทุนการบริการ

- เพิ่มประสิทธิภาพการประมวลผลคำขอของลูกค้า

หนังสือเกี่ยวกับ Big Data ที่ดีที่สุด

“โฉมหน้ามนุษย์ของบิ๊กดาต้า” โดย Rick Smolan และ Jennifer Erwitt

เหมาะสำหรับการศึกษาเบื้องต้นเกี่ยวกับเทคโนโลยีการประมวลผลข้อมูลขนาดใหญ่ – ช่วยให้คุณได้รับข้อมูลล่าสุดอย่างง่ายดายและชัดเจน ทำให้ชัดเจนว่าข้อมูลที่มีอยู่มากมายส่งผลต่อชีวิตประจำวันและทุกด้านของข้อมูลอย่างไร: วิทยาศาสตร์ ธุรกิจ การแพทย์ ฯลฯ มีภาพประกอบจำนวนมาก ดังนั้นจึงสามารถรับรู้ได้โดยไม่ต้องใช้ความพยายามมาก

บทนำสู่การทำเหมืองข้อมูลโดย Pang-Ning Tan, Michael Steinbach และ Vipin Kumar

หนังสือที่เป็นประโยชน์สำหรับผู้เริ่มต้นเกี่ยวกับ Big Data ซึ่งอธิบายวิธีการทำงานกับข้อมูลขนาดใหญ่ในลักษณะ “จากง่ายไปซับซ้อน” ครอบคลุมประเด็นสำคัญมากมายในระยะเริ่มต้น: การเตรียมตัวสำหรับการประมวลผล การสร้างภาพ OLAP ตลอดจนวิธีการวิเคราะห์และจัดประเภทข้อมูลบางวิธี

Python Machine Learning โดย Sebastian Raska

คู่มือปฏิบัติในการใช้งานและทำงานกับข้อมูลขนาดใหญ่โดยใช้ภาษาการเขียนโปรแกรม Python เหมาะสำหรับทั้งนักศึกษาวิศวกรรมศาสตร์และมืออาชีพที่ต้องการเพิ่มพูนความรู้

“Hadoop for Dummies”, Dirk Derus, Paul S. Zikopoulos, Roman B. Melnik

Hadoop เป็นโปรเจ็กต์ที่ออกแบบมาโดยเฉพาะเพื่อทำงานกับโปรแกรมแบบกระจายที่จัดระเบียบการดำเนินการกับโหนดหลายพันโหนดพร้อมกัน ความคุ้นเคยจะช่วยให้เข้าใจรายละเอียดเพิ่มเติมเกี่ยวกับการประยุกต์ใช้ข้อมูลขนาดใหญ่ในทางปฏิบัติ