Thuật ngữ “dữ liệu lớn” theo nghĩa đen có nghĩa là một lượng lớn thông tin được lưu trữ trên bất kỳ phương tiện nào.

- Nguồn dữ liệu lớn

- Lịch sử hình thành và phát triển của Dữ liệu lớn

- Các kỹ thuật và phương pháp phân tích và xử lý dữ liệu lớn

- Triển vọng và xu hướng phát triển dữ liệu lớn

- Dữ liệu lớn trong tiếp thị và kinh doanh

- Ví dụ về việc sử dụng Dữ liệu lớn

- Các vấn đề về dữ liệu lớn

- Thị trường công nghệ dữ liệu lớn ở Nga và trên toàn thế giới

- Những cuốn sách hay nhất về Dữ liệu lớn

Hơn nữa, khối lượng này quá lớn nên việc xử lý nó bằng phần mềm hoặc phần cứng thông thường là không thực tế và trong một số trường hợp, điều đó là hoàn toàn không thể.

Dữ liệu lớn không chỉ là bản thân dữ liệu mà còn là công nghệ để xử lý và sử dụng chúng, các phương pháp tìm kiếm thông tin cần thiết trong mảng lớn. Vấn đề dữ liệu lớn vẫn còn bỏ ngỏ và quan trọng đối với bất kỳ hệ thống nào đã tích lũy nhiều loại thông tin trong nhiều thập kỷ.

Nguồn dữ liệu lớn

Mạng xã hội là một ví dụ về nguồn dữ liệu lớn điển hình – mỗi hồ sơ hoặc trang công khai là một phần nhỏ trong đại dương thông tin phi cấu trúc. Hơn nữa, bất kể lượng thông tin được lưu trữ trong một hồ sơ cụ thể là bao nhiêu, tương tác với từng người dùng phải nhanh nhất có thể.

Dữ liệu lớn không ngừng được tích lũy trong hầu hết các lĩnh vực của cuộc sống con người. Điều này bao gồm bất kỳ ngành nào liên quan đến tương tác của con người hoặc máy tính. Đó là các phương tiện truyền thông xã hội, y học và lĩnh vực ngân hàng, cũng như các hệ thống thiết bị nhận nhiều kết quả tính toán hàng ngày. Ví dụ, các quan sát thiên văn, thông tin khí tượng và thông tin từ các thiết bị định vị Trái đất.

Thông tin từ các hệ thống theo dõi khác nhau trong thời gian thực cũng được gửi đến máy chủ của một công ty cụ thể. Cơ sở phát sóng truyền hình và đài phát thanh, cuộc gọi của các nhà khai thác di động – sự tương tác của mỗi cá nhân với họ là tối thiểu, nhưng tổng thể, tất cả thông tin này trở thành dữ liệu lớn.

Công nghệ dữ liệu lớn đã trở thành một phần không thể thiếu đối với R & amp; D và thương mại. Hơn nữa, họ đang bắt đầu nắm bắt lĩnh vực hành chính công – và ở mọi nơi, cần phải có các hệ thống lưu trữ và xử lý thông tin ngày càng hiệu quả hơn.

Lịch sử hình thành và phát triển của Dữ liệu lớn

Thuật ngữ “dữ liệu lớn” lần đầu tiên xuất hiện trên báo chí vào năm 2008, khi biên tập viên Clifford Lynch của Nature xuất bản một bài báo về cách thúc đẩy tương lai của khoa học với sự trợ giúp của công nghệ dữ liệu lớn. Cho đến năm 2009, thuật ngữ này chỉ được xem xét dưới góc độ phân tích khoa học, nhưng sau khi phát hành thêm một số bài báo, báo chí bắt đầu sử dụng rộng rãi khái niệm Dữ liệu lớn – và vẫn tiếp tục sử dụng ở thời điểm hiện tại.

Vào năm 2010, những nỗ lực đầu tiên để giải quyết vấn đề ngày càng tăng của dữ liệu lớn bắt đầu xuất hiện. Các sản phẩm phần mềm được phát hành nhằm mục đích giảm thiểu rủi ro khi sử dụng các mảng thông tin khổng lồ.

Đến năm 2011, các công ty lớn như Microsoft, Oracle, EMC và IBM bắt đầu quan tâm đến dữ liệu lớn – họ là những công ty đầu tiên sử dụng Dữ liệu lớn trong chiến lược phát triển của mình và khá thành công.

Các trường đại học bắt đầu nghiên cứu dữ liệu lớn như một môn học riêng biệt vào năm 2013 – bây giờ không chỉ khoa học dữ liệu, mà cả kỹ thuật, cùng với các môn máy tính, đang giải quyết các vấn đề trong lĩnh vực này.

Các kỹ thuật và phương pháp phân tích và xử lý dữ liệu lớn

Các phương pháp phân tích và xử lý dữ liệu chính bao gồm:

Phương pháp lớp hoặc khai thác dữ liệu

Các phương pháp này khá nhiều, nhưng chúng thống nhất với nhau bởi một điều: các công cụ toán học được sử dụng cùng với các thành tựu trong lĩnh vực công nghệ thông tin.

Nguồn lực cộng đồng

Kỹ thuật này cho phép bạn lấy dữ liệu đồng thời từ nhiều nguồn và số lượng dữ liệu sau thực tế là không giới hạn.

Thử nghiệm A / B

Từ toàn bộ lượng dữ liệu, một tập hợp phần tử điều khiển được chọn, được so sánh lần lượt với các tập hợp tương tự khác, trong đó một trong các phần tử đã được thay đổi. Tiến hành các thử nghiệm như vậy giúp xác định biến động tham số nào có ảnh hưởng lớn nhất đến quần thể đối chứng. Nhờ vào khối lượng Dữ liệu lớn, có thể thực hiện một số lượng lớn các lần lặp lại, với mỗi lần lặp lại đều đạt đến kết quả đáng tin cậy nhất.

Phân tích dự đoán

Các chuyên gia trong lĩnh vực này cố gắng dự đoán và lên kế hoạch trước cho đối tượng bị kiểm soát sẽ hành xử như thế nào để đưa ra quyết định có lợi nhất trong tình huống này.

Máy học (trí tuệ nhân tạo)

Nó dựa trên phân tích thực nghiệm của thông tin và việc xây dựng các thuật toán tự học cho các hệ thống sau đó.

Phân tích mạng

Phương pháp phổ biến nhất để nghiên cứu mạng xã hội – sau khi nhận được dữ liệu thống kê, các nút được tạo trong lưới sẽ được phân tích, tức là các tương tác giữa người dùng cá nhân và cộng đồng của họ.

Triển vọng và xu hướng phát triển dữ liệu lớn

Năm 2017, khi dữ liệu lớn không còn là thứ gì đó quá mới mẻ và ít người biết đến, tầm quan trọng của nó không những không giảm mà thậm chí còn tăng lên. Giờ đây, các chuyên gia đang đánh cược rằng việc phân tích lượng lớn dữ liệu sẽ trở nên khả dụng không chỉ cho các tổ chức khổng lồ mà còn cho các doanh nghiệp vừa và nhỏ. Cách tiếp cận này được lên kế hoạch thực hiện bằng cách sử dụng các thành phần sau:

Bộ nhớ đám mây

Việc lưu trữ và xử lý dữ liệu đang trở nên nhanh hơn và tiết kiệm hơn – so với chi phí duy trì trung tâm dữ liệu của riêng bạn và khả năng mở rộng nhân viên, thuê một đám mây dường như là một giải pháp thay thế rẻ hơn nhiều.

Sử dụng dữ liệu tối

Cái gọi là “dữ liệu tối” là tất cả thông tin chưa được số hóa về một công ty không đóng vai trò chủ chốt trong việc sử dụng trực tiếp, nhưng có thể là lý do để chuyển sang định dạng lưu trữ thông tin mới.

Trí tuệ nhân tạo và học sâu

Công nghệ học tập bằng trí thông minh máy, mô phỏng cấu trúc và hoạt động của não người, là công nghệ phù hợp nhất để xử lý một lượng lớn thông tin thay đổi liên tục. Trong trường hợp này, máy sẽ làm mọi thứ mà một người phải làm, nhưng khả năng xảy ra lỗi sẽ giảm đáng kể.

Chuỗi khối

Công nghệ này cho phép bạn tăng tốc và đơn giản hóa nhiều giao dịch Internet, bao gồm cả các giao dịch quốc tế. Một ưu điểm khác của Blockchain là nó làm giảm chi phí giao dịch.

Tự phục vụ và giảm giá

Vào năm 2017, nó được lên kế hoạch giới thiệu “nền tảng tự phục vụ” – đây là những nền tảng miễn phí, nơi đại diện của các doanh nghiệp vừa và nhỏ sẽ có thể đánh giá độc lập dữ liệu mà họ lưu trữ và hệ thống hóa nó.

Dữ liệu lớn trong tiếp thị và kinh doanh

Tất cả các chiến lược tiếp thị bằng cách nào đó đều dựa trên việc thao túng thông tin và phân tích dữ liệu hiện có. Đó là lý do tại sao việc sử dụng dữ liệu lớn có thể dự đoán và giúp điều chỉnh sự phát triển hơn nữa của công ty.

Ví dụ: phiên đấu giá RTB được tạo trên cơ sở dữ liệu lớn cho phép bạn sử dụng quảng cáo hiệu quả hơn – một sản phẩm nhất định sẽ chỉ được hiển thị cho nhóm người dùng quan tâm đến việc mua sản phẩm đó.

Lợi ích của việc sử dụng công nghệ dữ liệu lớn trong tiếp thị và kinh doanh là gì?

- Với sự trợ giúp của họ, bạn có thể tạo các dự án mới nhanh hơn nhiều, những dự án này có khả năng trở nên phổ biến đối với người mua.

- Chúng giúp liên kết các yêu cầu của khách hàng với dịch vụ hiện có hoặc dịch vụ đã lên kế hoạch và do đó điều chỉnh chúng.

- Phương pháp dữ liệu lớn cho phép bạn đánh giá mức độ hài lòng hiện tại của tất cả người dùng và từng người dùng riêng lẻ.

- Việc tăng lòng trung thành của khách hàng đạt được thông qua các phương pháp xử lý dữ liệu lớn.

- Việc thu hút đối tượng mục tiêu trên Internet ngày càng trở nên dễ dàng hơn do khả năng kiểm soát lượng dữ liệu khổng lồ.

Ví dụ: một trong những dịch vụ phổ biến nhất để dự đoán khả năng phổ biến của một sản phẩm cụ thể là Google.trends. Nó được sử dụng rộng rãi bởi các nhà tiếp thị và nhà phân tích, cho phép họ có được số liệu thống kê về việc sử dụng một sản phẩm nhất định trong quá khứ và dự báo cho mùa tiếp theo. Điều này cho phép các nhà lãnh đạo công ty phân phối ngân sách quảng cáo hiệu quả hơn, xác định xem nên đầu tư tiền vào lĩnh vực nào là tốt nhất.

Ví dụ về việc sử dụng Dữ liệu lớn

Việc tích cực đưa công nghệ Dữ liệu lớn vào thị trường và vào cuộc sống hiện đại bắt đầu ngay sau khi chúng bắt đầu được sử dụng bởi các công ty nổi tiếng thế giới có khách hàng ở hầu hết mọi nơi trên toàn cầu.

Đây là những gã khổng lồ xã hội như Facebook và Google, IBM., Cũng như các cấu trúc tài chính như Master Card, VISA và Bank of America.

Ví dụ, IBM đang áp dụng các kỹ thuật dữ liệu lớn vào các giao dịch tiền mặt. Với sự giúp đỡ của họ, các giao dịch gian lận đã được phát hiện thêm 15%, điều này làm tăng số tiền được bảo vệ lên 60%. Các vấn đề về dương tính giả của hệ thống cũng đã được giải quyết – số lượng của chúng đã giảm hơn một nửa.

Tương tự, VISA đã sử dụng Dữ liệu lớn, theo dõi các nỗ lực gian lận để thực hiện một giao dịch cụ thể. Nhờ đó, hàng năm họ tiết kiệm được hơn 2 tỷ đô la Mỹ từ việc rò rỉ.

Bộ Lao động Đức đã cố gắng cắt giảm 10 tỷ euro chi phí bằng cách triển khai hệ thống dữ liệu lớn trong công tác cấp phát trợ cấp thất nghiệp. Đồng thời, người ta tiết lộ rằng 1/5 số công dân nhận được những lợi ích này mà không cần biện minh.

Dữ liệu lớn cũng không vượt qua được ngành công nghiệp game. Do đó, các nhà phát triển của World of Tanks đã tiến hành nghiên cứu thông tin về tất cả người chơi và so sánh các chỉ số có sẵn về hoạt động của họ. Điều này giúp dự đoán những người chơi có thể tham gia trong tương lai – dựa trên các giả định được đưa ra, đại diện của tổ chức có thể tương tác với người dùng hiệu quả hơn.

Các tổ chức đáng chú ý sử dụng dữ liệu lớn còn có HSBC, Nasdaq, Coca-Cola, Starbucks và AT & amp; T.

Các vấn đề về dữ liệu lớn

Vấn đề lớn nhất với dữ liệu lớn là chi phí xử lý nó. Điều này có thể bao gồm cả thiết bị đắt tiền và chi phí tiền công cho các chuyên gia có trình độ có khả năng cung cấp lượng thông tin khổng lồ. Rõ ràng, thiết bị sẽ phải được cập nhật thường xuyên để không bị mất hiệu suất tối thiểu khi lượng dữ liệu tăng lên.

Vấn đề thứ hai một lần nữa liên quan đến lượng lớn thông tin cần được xử lý. Ví dụ, nếu một nghiên cứu không đưa ra 2-3 kết quả mà là một số lượng lớn các kết quả, thì rất khó để duy trì tính khách quan và chỉ chọn lọc từ dòng dữ liệu chung mà sẽ có tác động thực sự đến trạng thái của một hiện tượng.

Vấn đề về quyền riêng tư của Dữ liệu lớn. Với việc hầu hết các dịch vụ chăm sóc khách hàng chuyển sang sử dụng dữ liệu trực tuyến, rất dễ trở thành mục tiêu tiếp theo của tội phạm mạng. Ngay cả khi chỉ lưu trữ thông tin cá nhân mà không thực hiện bất kỳ giao dịch trực tuyến nào cũng có thể gây ra những hậu quả không mong muốn cho khách hàng lưu trữ đám mây.

Vấn đề mất thông tin. Các biện pháp phòng ngừa không chỉ giới hạn ở việc sao lưu dữ liệu một lần đơn giản mà phải tạo ít nhất 2-3 bản sao lưu của bộ nhớ. Tuy nhiên, khi khối lượng tăng lên, độ phức tạp của dự phòng cũng tăng lên – và các chuyên gia CNTT đang cố gắng tìm ra giải pháp tốt nhất cho vấn đề này.

Thị trường công nghệ dữ liệu lớn ở Nga và trên toàn thế giới

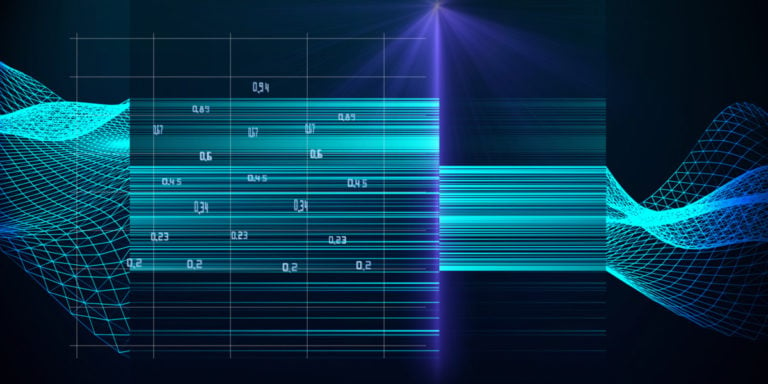

Tính đến năm 2014, 40% thị trường dữ liệu lớn là dịch vụ. Thấp hơn một chút (38%) so với chỉ tiêu này là doanh thu từ việc sử dụng Dữ liệu lớn trong thiết bị máy tính. 22% còn lại là ở phần mềm.

Các sản phẩm hữu ích nhất trong phân khúc toàn cầu để giải quyết các vấn đề Dữ liệu lớn, theo thống kê, là nền tảng phân tích In-memory và NoSQL. Tương ứng, 15 và 12% thị trường được chiếm lĩnh bởi phần mềm phân tích tệp nhật ký và nền tảng Columnar. Nhưng trên thực tế, Hadoop / MapReduce đối phó với các vấn đề của dữ liệu lớn không hiệu quả lắm.

Kết quả của việc triển khai công nghệ dữ liệu lớn:

- tăng trưởng về chất lượng dịch vụ khách hàng;

- tối ưu hóa việc tích hợp chuỗi cung ứng;

- tối ưu hóa lập kế hoạch tổ chức;

- tăng tốc độ tương tác với khách hàng;

- cải thiện hiệu quả xử lý các yêu cầu của khách hàng;

- giảm chi phí dịch vụ;

- tối ưu hóa việc xử lý các yêu cầu của khách hàng.

Những cuốn sách hay nhất về Dữ liệu lớn

“Khuôn mặt con người của Dữ liệu lớn” của Rick Smolan và Jennifer Erwitt

Thích hợp cho nghiên cứu ban đầu về công nghệ xử lý dữ liệu lớn – nó dễ dàng và rõ ràng mang đến cho bạn thông tin cập nhật. Nó nói rõ rằng lượng thông tin dồi dào đã ảnh hưởng như thế nào đến cuộc sống hàng ngày và tất cả các lĩnh vực của nó: khoa học, kinh doanh, y học, v.v. Chứa nhiều hình ảnh minh họa, vì vậy nó được nhận thức mà không cần nỗ lực nhiều.

Giới thiệu về Khai thác dữ liệu của Pang-Ning Tan, Michael Steinbach và Vipin Kumar

Đây cũng là một cuốn sách hữu ích cho người mới bắt đầu về Dữ liệu lớn, giải thích cách làm việc với dữ liệu lớn theo cách “từ đơn giản đến phức tạp”. Nó bao gồm nhiều điểm quan trọng ở giai đoạn đầu: chuẩn bị cho quá trình xử lý, trực quan hóa, OLAP, cũng như một số phương pháp phân tích và phân loại dữ liệu.

Học máy Python của Sebastian Raska

Hướng dẫn thực tế để sử dụng và làm việc với dữ liệu lớn bằng ngôn ngữ lập trình Python. Thích hợp cho cả sinh viên kỹ thuật và các chuyên gia muốn đào sâu kiến thức của họ.

“Hadoop for Dummies”, Dirk Derus, Paul S. Zikopoulos, Roman B. Melnik

Hadoop là một dự án được thiết kế đặc biệt để làm việc với các chương trình phân tán tổ chức thực hiện các hành động trên hàng nghìn nút cùng một lúc. Việc làm quen với nó sẽ giúp hiểu chi tiết hơn về ứng dụng thực tế của dữ liệu lớn.