“Büyük veri” terimi, kelimenin tam anlamıyla, herhangi bir ortamda depolanan büyük miktarda bilgi anlamına gelir.

- Büyük Veri Kaynakları

- Büyük Verinin ortaya çıkışı ve gelişiminin tarihi

- Büyük verileri analiz etme ve işleme teknikleri ve yöntemleri

- Büyük veri geliştirme beklentileri ve eğilimleri

- Pazarlama ve iş dünyasında büyük veri

- Büyük Veri kullanımına ilişkin örnekler

- Büyük Veri Sorunları

- Rusya'da ve dünya çapında büyük veri teknolojisi pazarı

- Büyük Veri üzerine en iyi kitaplar

Ayrıca, bu hacim o kadar büyüktür ki, olağan yazılım veya donanım kullanılarak işlenmesi pratik değildir ve bazı durumlarda tamamen imkansızdır.

Büyük Veri, yalnızca verinin kendisi değil, aynı zamanda bunları işleme ve kullanma teknolojileri, büyük dizilerde gerekli bilgileri bulma yöntemleridir. Büyük veri sorunu, onlarca yıldır çok çeşitli bilgiler biriktiren herhangi bir sistem için hala açık ve hayatidir.

Büyük Veri Kaynakları

Sosyal ağlar, tipik bir büyük veri kaynağı örneğidir – her profil veya genel sayfa, yapılandırılmamış bir bilgi okyanusunda küçük bir damladır. Ayrıca, belirli bir profilde saklanan bilgi miktarından bağımsız olarak, kullanıcıların her biri ile etkileşim mümkün olduğunca hızlı olmalıdır.

Büyük veri, insan yaşamının hemen her alanında sürekli olarak birikmektedir. Bu, insan etkileşimleri veya bilgi işlemle ilgili herhangi bir endüstriyi içerir. Bunlar sosyal medya, tıp ve bankacılık sektörünün yanı sıra günlük hesaplamaların sayısız sonucunu alan cihaz sistemleridir. Örneğin, astronomik gözlemler, meteorolojik bilgiler ve Yer sondaj cihazlarından gelen bilgiler.

Çeşitli izleme sistemlerinden gelen bilgiler gerçek zamanlı olarak belirli bir şirketin sunucularına da gönderilir. Televizyon ve radyo yayıncılığı, mobil operatörlerin çağrı tabanları – her bir kişinin onlarla etkileşimi minimumdur, ancak toplu olarak, tüm bu bilgiler büyük veri haline gelir.

Büyük veri teknolojileri, Ar-Ge ve ticaretin ayrılmaz bir parçası haline geldi. Ayrıca, kamu yönetimi alanını ele geçirmeye başlıyorlar – ve her yerde bilgi depolamak ve işlemek için daha verimli sistemlerin tanıtılması gerekiyor.

Büyük Verinin ortaya çıkışı ve gelişiminin tarihi

“Büyük veri” terimi ilk olarak 2008 yılında Nature editörü Clifford Lynch’in büyük veri teknolojilerinin yardımıyla bilimin geleceğini nasıl ilerletebileceğine dair bir makale yayınladığı zaman basında ortaya çıktı. 2009 yılına kadar, bu terim yalnızca bilimsel analiz açısından değerlendirildi, ancak birkaç makalenin daha yayınlanmasından sonra, basın Büyük Veri kavramını yaygın olarak kullanmaya başladı – ve şu anda kullanmaya devam ediyor.

2010 yılında, büyüyen büyük veri sorununu çözmeye yönelik ilk girişimler ortaya çıkmaya başladı. Eylemleri büyük bilgi dizilerini kullanırken riskleri en aza indirmeyi amaçlayan yazılım ürünleri piyasaya sürüldü.

2011 yılına gelindiğinde, Microsoft, Oracle, EMC ve IBM gibi büyük şirketler büyük verilerle ilgilenmeye başladılar – Büyük verileri geliştirme stratejilerinde ilk kullananlar oldular ve oldukça başarılı oldular.

Üniversiteler, 2013’te zaten büyük verileri ayrı bir konu olarak incelemeye başladılar – şimdi sadece veri bilimleri değil, aynı zamanda mühendislik, bilgisayar konularıyla birlikte bu alandaki problemlerle uğraşıyor.

Büyük verileri analiz etme ve işleme teknikleri ve yöntemleri

Ana veri analizi ve işleme yöntemleri şunları içerir:

Sınıf yöntemleri veya veri madenciliği

Bu yöntemler oldukça fazladır, ancak bir şey tarafından birleştirilirler: bilgi teknolojisi alanındaki başarılarla birlikte kullanılan matematiksel araçlar.

Kitle kaynak kullanımı

Bu teknik, birkaç kaynaktan aynı anda veri elde etmenizi sağlar ve ikincisinin sayısı pratik olarak sınırsızdır.

A/B testi

Tüm veri miktarından, öğelerden birinin değiştirildiği diğer benzer kümelerle sırayla karşılaştırılan bir kontrol öğeleri kümesi seçilir. Bu tür testlerin yapılması, kontrol popülasyonu üzerinde hangi parametre dalgalanmalarının en büyük etkiye sahip olduğunu belirlemeye yardımcı olur. Büyük Veri hacimleri sayesinde, her biri en güvenilir sonuca yaklaşan çok sayıda yineleme gerçekleştirmek mümkündür.

Tahmini Analizler

Bu alandaki uzmanlar, bu durumda en avantajlı kararı verebilmek için kontrol edilen nesnenin nasıl davranacağını önceden tahmin etmeye ve planlamaya çalışır.

Makine öğrenimi (yapay zeka)

Bilginin ampirik bir analizine ve ardından sistemler için kendi kendine öğrenme algoritmalarının oluşturulmasına dayanır.

Ağ analizi

Sosyal ağları incelemek için en yaygın yöntem – istatistiksel verileri aldıktan sonra, ızgarada oluşturulan düğümler, yani bireysel kullanıcılar ve toplulukları arasındaki etkileşimler analiz edilir.

Büyük veri geliştirme beklentileri ve eğilimleri

Büyük verinin artık yeni ve bilinmeyen bir şey olmadığı 2017 yılında önemi azalmakla kalmadı, hatta arttı. Artık uzmanlar, büyük miktarda verinin analizinin yalnızca dev kuruluşlar için değil, aynı zamanda küçük ve orta ölçekli işletmeler için de mümkün olacağına bahse giriyor. Bu yaklaşımın aşağıdaki bileşenler kullanılarak uygulanması planlanmaktadır:

Bulut Depolama

Veri depolama ve işleme, daha hızlı ve daha ekonomik hale geliyor – kendi veri merkezinizi korumanın maliyetleri ve olası personel genişlemesi ile karşılaştırıldığında, bir bulut kiralamak çok daha ucuz bir alternatif gibi görünüyor.

Karanlık Verileri Kullanma

Sözde “karanlık veri”, doğrudan kullanımında önemli bir rol oynamayan, ancak yeni bir bilgi depolama formatına geçiş için bir neden olarak hizmet edebilecek bir şirket hakkında tüm sayısallaştırılmamış bilgilerdir.

Yapay Zeka ve Derin Öğrenme

İnsan beyninin yapısını ve işleyişini taklit eden makine zekası öğrenme teknolojisi, sürekli değişen büyük miktarda bilgiyi işlemek için en uygun olanıdır. Bu durumda, makine bir kişinin yapması gereken her şeyi yapacaktır, ancak hata olasılığı büyük ölçüde azaltılmıştır.

Blockchain

Bu teknoloji, uluslararası olanlar da dahil olmak üzere çok sayıda İnternet işlemini hızlandırmanıza ve basitleştirmenize olanak tanır. Blockchain’in bir diğer avantajı da işlem maliyetlerini düşürmesidir.

Self servis ve fiyat indirimleri

2017 yılında “self servis platformlar”ın tanıtılması planlanmaktadır – bunlar küçük ve orta ölçekli işletmelerin temsilcilerinin depoladıkları verileri bağımsız olarak değerlendirebilecekleri ve sistemleştirebilecekleri ücretsiz platformlardır.

Pazarlama ve iş dünyasında büyük veri

Tüm pazarlama stratejileri bir şekilde bilgilerin manipülasyonuna ve mevcut verilerin analizine dayanmaktadır. Bu nedenle, büyük veri kullanımı şirketin daha da gelişmesini öngörebilir ve ayarlamayı mümkün kılabilir.

Örneğin, büyük veriler temelinde oluşturulan bir RTB açık artırması, reklamları daha verimli kullanmanıza olanak tanır – belirli bir ürün yalnızca onu satın almakla ilgilenen kullanıcı grubuna gösterilir.

Pazarlama ve iş dünyasında büyük veri teknolojilerini kullanmanın faydası nedir?

- Onların yardımıyla, alıcılar arasında popüler hale gelecek yeni projeleri çok daha hızlı oluşturabilirsiniz.

- Müşteri gereksinimlerini mevcut veya planlanmış bir hizmetle ilişkilendirmeye ve böylece bunları düzenlemeye yardımcı olurlar.

- Büyük veri yöntemleri, tüm kullanıcıların ve her birinin mevcut memnuniyet derecesini ayrı ayrı değerlendirmenize olanak tanır.

- Müşteri bağlılığını artırmak, büyük veri işleme yöntemleriyle sağlanır.

- Büyük miktarda veriyi kontrol etme yeteneği nedeniyle, hedef kitleyi İnternet’te çekmek daha kolay hale geliyor.

Örneğin, belirli bir ürünün olası popülerliğini tahmin etmeye yönelik en popüler hizmetlerden biri Google.trends’dir. Pazarlamacılar ve analistler tarafından yaygın olarak kullanılır ve belirli bir ürünün geçmişteki kullanımına ilişkin istatistikler almalarına ve gelecek sezon için tahmin yapmalarına olanak tanır. Bu, şirket liderlerinin reklam bütçesini daha etkin bir şekilde dağıtmasına ve hangi alana para yatırmanın en iyi olduğunu belirlemesine olanak tanır.

Büyük Veri kullanımına ilişkin örnekler

Büyük Veri teknolojilerinin pazara ve modern hayata aktif girişi, dünyanın hemen her köşesinde müşterisi olan dünyaca ünlü şirketler tarafından kullanılmaya başlanmasından hemen sonra başlamıştır.

Bunlar Facebook ve Google, IBM gibi sosyal devler, Master Card, VISA ve Bank of America gibi finansal yapılar.

Örneğin, IBM, nakit işlemlere büyük veri teknikleri uyguluyor. Onların yardımıyla, %15 daha fazla hileli işlem tespit edildi ve bu da korunan fon miktarını %60 oranında artırdı. Sistemin yanlış pozitifleri ile ilgili sorunlar da çözüldü – sayıları yarıdan fazla azaldı.

VISA, benzer şekilde, belirli bir işlemi gerçekleştirmek için yapılan hileli girişimleri izleyerek Büyük Veri’yi kullandı. Bu sayede her yıl kaçaktan 2 milyar ABD dolarından fazla tasarruf sağlıyorlar.

Almanya Çalışma Bakanlığı, işsizlik maaşı verme çalışmalarında büyük bir veri sistemi uygulayarak maliyetleri 10 milyar avro düşürmeyi başardı. Aynı zamanda, vatandaşların beşte birinin bu yardımları gerekçesiz olarak aldığı ortaya çıktı.

Büyük Veri, oyun endüstrisini de atlamadı. Böylece, World of Tanks geliştiricileri, tüm oyuncular hakkında bir bilgi çalışması yaptı ve faaliyetlerinin mevcut göstergelerini karşılaştırdı. Bu, gelecekteki olası oyuncu kaybını tahmin etmeye yardımcı oldu – yapılan varsayımlara dayanarak, kuruluş temsilcileri kullanıcılarla daha etkili bir şekilde etkileşime girebildi.

Büyük veri kullanan önemli kuruluşlar arasında HSBC, Nasdaq, Coca-Cola, Starbucks ve AT&T de yer alıyor.

Büyük Veri Sorunları

Büyük veri ile ilgili en büyük sorun, onu işlemenin maliyetidir. Bu, hem pahalı ekipmanı hem de büyük miktarda bilgiye hizmet edebilecek kalifiye uzmanlar için ücret maliyetini içerebilir. Açıkçası, veri miktarı arttıkça minimum performansını kaybetmemesi için ekipmanın düzenli olarak güncellenmesi gerekecektir.

İkinci sorun yine işlenmesi gereken büyük miktarda bilgi ile ilgilidir. Örneğin, bir çalışma 2-3 değil, çok sayıda sonuç veriyorsa, nesnel kalmak ve genel veri akışından yalnızca bir olgunun durumu üzerinde gerçek bir etkisi olacak olanları seçmek çok zordur.

Büyük Veri gizlilik sorunu. Çoğu müşteri hizmetleri hizmetinin çevrimiçi veri kullanımına geçmesiyle, siber suçlular için bir sonraki hedef olmak çok kolay. Herhangi bir çevrimiçi işlem yapmadan yalnızca kişisel bilgileri depolamak bile, bulut depolama müşterileri için istenmeyen sonuçlarla dolu olabilir.

Bilgi kaybı sorunu. Önlemler, verilerin tek seferlik basit bir yedeklemesiyle sınırlı kalmayıp, depolama alanının en az 2-3 yedek kopyasının alınmasını gerektirir. Ancak, hacim arttıkça yedekliliğin karmaşıklığı da artıyor ve BT uzmanları bu soruna en iyi çözümü bulmaya çalışıyor.

Rusya’da ve dünya çapında büyük veri teknolojisi pazarı

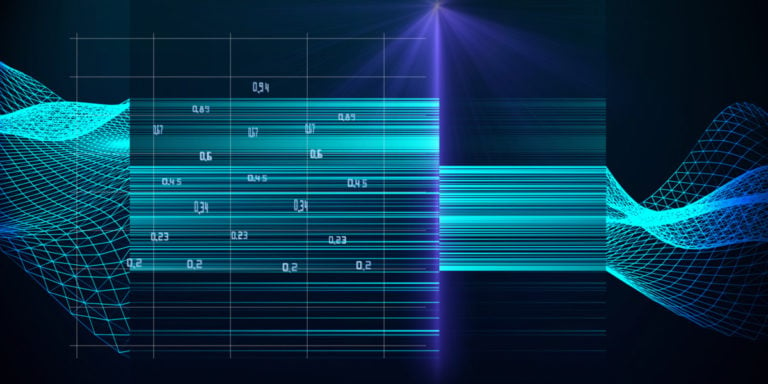

2014 yılı itibarıyla büyük veri pazarının %40’ı hizmetlerdir. Bu göstergeden biraz daha düşük (%38), bilgisayar ekipmanında Büyük Veri kullanımından elde edilen gelirdir. Kalan %22 ise yazılımda.

İstatistiklere göre Big Data problemlerinin çözümü için global segmentte en kullanışlı ürünler In-memory ve NoSQL analitik platformlarıdır. Pazarın sırasıyla yüzde 15 ve yüzde 12’si Log-file analitik yazılımı ve Columnar platformları tarafından işgal ediliyor. Ancak Hadoop / MapReduce pratikte büyük veri sorunlarıyla başa çıkmak çok etkili değil.

Büyük veri teknolojilerini uygulamanın sonuçları:

- müşteri hizmetlerinin kalitesinde büyüme;

- tedarik zinciri entegrasyonunu optimize etme;

- kuruluş planlama optimizasyonu;

- müşterilerle etkileşimin hızlandırılması;

- müşteri isteklerini işleme verimliliğini artırma;

- hizmet maliyetlerini azaltmak;

- müşteri isteklerinin işlenmesini optimize etme.

Büyük Veri üzerine en iyi kitaplar

Rick Smolan ve Jennifer Erwitt’in yazdığı “Büyük Verinin İnsan Yüzü”

Büyük veri işleme teknolojilerinin ilk çalışması için uygundur – sizi kolay ve net bir şekilde güncel tutar. Bilgi bolluğunun günlük yaşamı ve tüm alanlarını nasıl etkilediğini açıkça ortaya koyuyor: bilim, işletme, tıp, vb. Çok sayıda illüstrasyon içeriyor, bu yüzden fazla çaba sarf etmeden algılanıyor.

Pang-Ning Tan, Michael Steinbach ve Vipin Kumar’dan Veri Madenciliğine Giriş

Ayrıca, Büyük Veri konusunda yeni başlayanlar için, büyük verilerle “basitten karmaşığa” nasıl çalışılacağını açıklayan yararlı bir kitap. İlk aşamadaki birçok önemli noktayı kapsar: işleme, görselleştirme, OLAP için hazırlık ve ayrıca bazı verileri analiz etme ve sınıflandırma yöntemleri.

Sebastian Raska’dan Python Makine Öğrenimi

Python programlama dilini kullanarak büyük verileri kullanmak ve bunlarla çalışmak için pratik bir kılavuz. Hem mühendislik öğrencileri hem de bilgilerini derinleştirmek isteyen profesyoneller için uygundur.

“Aptallar için Hadoop”, Dirk Derus, Paul S. Zikopoulos, Roman B. Melnik

Hadoop, aynı anda binlerce düğümde eylemlerin yürütülmesini organize eden dağıtılmış programlarla çalışmak üzere özel olarak tasarlanmış bir projedir. Onunla tanışma, büyük verilerin pratik uygulamasını daha ayrıntılı olarak anlamaya yardımcı olacaktır.